Предметный рейтинг университетов России "Рейтинг факультетов"-2016

Дмитрий Толмачев, Павел Кузнецов

«Пришел ко мне устраиваться на работу выпускник физико-технического факультета н-ского университета. Физтеховское образование это то, с чем в нашу компанию с удовольствием берут, но после собеседования выяснилось, что товарищ закончил кафедру иностранных языков и по специальности лингвист. Какое отношение это имеет к физтеху, я до сих пор гадаю» – рассказывает руководитель крупной ИТ-компании. Конечно, от подобных новаций голодных 90-х, когда к сильным советским университетским брендам пытались всеми силами прицепить все, что могло принести деньги, когда в одном вузе можно было обнаружить по несколько экономических факультетов, ведущие вузы по большому счету избавились. Но тема осталась: абитуриент что в России, что за рубежом выбирает не только (а иногда не столько) университет, но и факультет (или направление подготовки). Сильный абитуриент предпочтет изучать экономику в Высшей школе экономике, даже если в МИФИ будет аналогичное направление подготовки. И наоборот, , хотя оба университета имеют самые высокие рейтинги, входят во все возможные программы развития университетов. Ровно также действуют работодатели и академические партнеры.

Понимая это, составители пяти наиболее авторитетных международных рейтингов университетов ежегодно формируют не только общие, но и предметные рейтинги университетов мира. Однако есть две крупные проблемы для России. Во-первых, представленность российских университетов в этих рейтингах очень низка (17 вузов в предметном рейтинге QS, по 2-4 вуза из РФ в предметных рейтингах ARWU, THE, а также несколько в менее популярных CWTS Leiden и The U.S.News&World reports). Во-вторых, за исключением QS Subject ranking остальные рейтинги содержат настолько укрупненную разбивку предметных областей, что, к примеру, даже лидер в области физики не сможет попасть в лидеры предметного рейтинга THE соответствующей предметной области (physical sciences), поскольку последняя включает в себя также материаловедение, химию, математику и так далее. Ни один российский рейтинг университетов (наиболее известные составляют РА «Эксперт» и Интерфакс) позиции вузов в предметных областях до сих пор не измерял. Публикуемый рейтинг закрывает это «белое пятно» в рейтингах российских университетов.

Качество или скорость

Мы не ставим перед собой целью создать автономный российский рейтинг «факультетов» - как раз наоборот, одна из важнейших задач заключается в том, чтобы показать российским университетам трек, в конце которого их ждет вхождение в мировые предметные рейтинги. Поэтому основные критерии оценки (различные оценки на базе наукометрических показателей по научным журналам, индексируемым международными индексами научного цитирования) близки к тем, что используются международными рейтинговыми агентствами. Нетрудно заметить, что такая модель оценки применима только к исследовательским университетам, достижения которых можно измерить через качество научных публикаций. Это вузы, которые должны быть способны вести исследования в определенных областях науки на мировом уровне, а значит и давать в соответствующих областях образование того же класса. В России, как впрочем и в любой другой стране на это в какой-то перспективе могут претендовать вряд ли больше 20% (немногим более сотни) университетов. Что не отменяет необходимости существования еще нескольких сотен вузов, ориентированных на массовое образование. Размер вуза/факультета в рейтинге не учитывается, значение имеет размер соответствующего научного коллектива (который, в свою очередь, определяется числом публикующихся ученых, собственно публикаций и цитат). Огромный вуз, нацеленный на массовое образование, может не демонстрировать значимых научных результатов, и, наоборот, небольшой университет, формата Европейского университета в Санкт-Петербурге, может демонстрировать выдающиеся публикационные показатели в области своей специализации.

Вместе с тем мы считаем важным учесть несколько специфичных для России факторов.

Во-первых, качество роста. Известны примеры китайских «каруселей» публикаций, когда на уровне нескольких университетов для достижения высоких показателей в международных рейтингах применялись модели взаимного цитирования, которые искусственно «накачивали» данный показатель. Подобного рода примеры есть и в России. Поэтому существенный вес при оценке достижений российских вузов в научных областях мы придали качеству роста, с тем, чтобы исключить два самых распространенных приема: выходящее за рамки разумного самоцитирование (цитирование ученых своего университета) и использование «лояльных» научных журналов для увеличения числа индексируемых публикаций. Нетрудно увидеть на представленных графиках (см. рис.) несколько университетов, которые умудрились опубликовать в области экономики свыше 2/3 статей всего в одном журнале. Свыше десятка вузов, имеющих более менее заметные научные результаты в этой предметной области, цитируют себя и своих коллег из вуза более, чем в половине случаев ( а отдельные фигуранты – в 90-100%). В области естественных наук подобные статистические выбросы встречаются реже, однако также имеют место. Разработанная в рамках подготовки методики математическая модель кластеризации университетов по уровню самоцитирования и журналам позволила отчасти нивелировать этот эффект.

Другой фактор, также специфичный для России (и других стран, гед идут интесивные процессы реформирования систем образования) – низкий уровень включенности национальных научных журналов в индексацию международными индексами научного цитирования. Далеко не все национальные научные журналы, по уровню способные претендовать на включение в индексацию международными базами научного цитирования (Scopus и Web of science), включены в индексацию. Яркий пример в России – экономика. В этой области Россия мягко говоря не лидер, тем не менее два журнала – «Экономика Региона» (выпускается Институтом экономики Уро РАН и УрФУ) и «Форсайт» (Высшая школа экономики) вошли в Scopus. Вместе с тем такие общепризнанные лидеры этой предметной области, как «Вопросы экономики» и «Российский журнал менеджмента» ни одной из двух баз не индексируются. В естественных науках ситуация лучше, однако и там встречаются подобные искажения. Данную задачу в рамках методики нам решить не удалось, поскольку переход к оценки публикационной активности по Российскому индексу научного цитирования сразу включил бы в рассмотрение большое число низкоуровневых российских журналов. Возможно эту проблему можно будет решить в следующем издании рейтинга.

Третий важный момент методики – отказ от опросов. Три из пяти международных рейтингов включают в качестве важнейшего элемента опрос работодателей и академического сообщества. Не углубляясь в детали отметим, что смещенность выборки при опросах в пользу англоязычных стран дает сильные искажения в оценках репутации (справедливости ради отметим, что, как и в случае с научными журналами, ситуация с каждым годом усилиями рейтинговых агентств и российских университетов улучшается). Однако на данном этапе мы приняли решение отказаться от опроса, чтобы максимально снизить влияние субъективных факторов при формировании рейтинга.

Последнее, что надо отметить – это горизонт исследования. Основные международные рейтинги стремятся снизить волатильность позиций университетов и делают период рассмотрения более длинным (5 лет). Такая консервативность не позволяет увидеть быстрые изменения (а по некоторым ведущим российским вузам за последние несколько лет число публикаций выросло в два-три раза). В связи с этим период, за который учитывались публикации, был сокращен до 4 лет.

Результаты

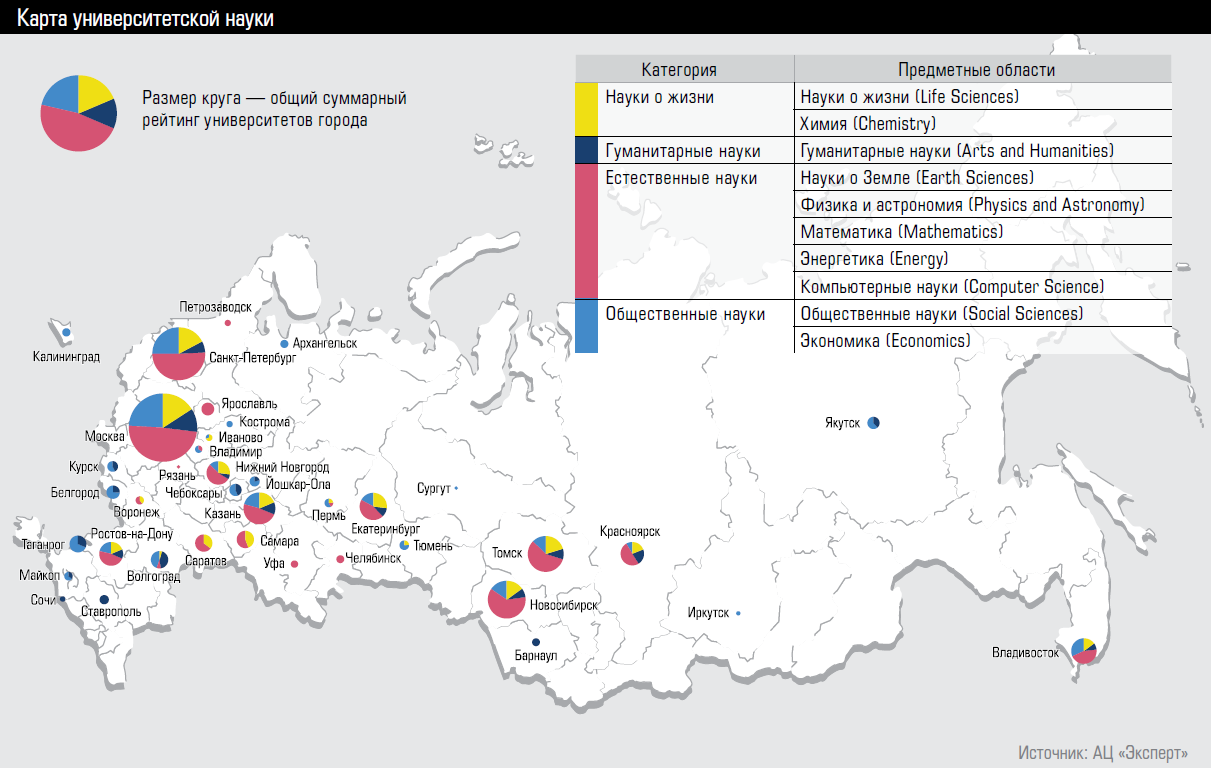

Каковы главные результаты? Во-первых, в рейтинг факультетов сумели войти свыше 8-ми десятков российских вузов, то есть – так или иначе – большая часть потенциальных кандидатов. Почти половина участников (35 университетов) вошли в число лидеров только по одному направлению. Среди них такие яркие монопрофильные университеты, как Российская экономическая школа (2-е место по экономике) и Европейский университет в Санкт-Петербурге (5-е место в общественных науках). На другом полюсе 6 университетов, которые попали во все предметные рейтинги: МГУ, СПбГУ, Новосибирский НИУ и три федеральных университета: Уральский, Дальневосточный и Казанский.

Первая пятерка позиций в каждом предметном ранжировании никаких сюрпризов не дает – те же вузы в основном входят в «хвосты» международных предметных рейтингов. Это МГУ, СПбГУ, Новосибирский НИУ, в естественных науках эту тройку «разбавляют» МФТИ и МИФИ, в гуманитарных – НИУ ВШЭ. Кроме того, в отдельных предметных областях появляются новые лидеры, вроде уже упомянутой РЭШки в экономике. Так, в компьютерных науках и в химии в пятерку лучших вошел ИТМО, в гуманитарных – два федеральных вуза (Сибирский и Казанский), в науках о жизни – Уральский федеральный и Санкт-Петербургский политех, в энергетике – Томский госуниверситет.

Еще интереснее новые игроки, до сих пор не фигурировавшие на заметных позициях ни в российских, ни в международных измерениях. Так, Белгородский университет вошел в 10-ку лучших в социальных науках, Тюменский государственный университет попал в лучшие в науках о жизни, обеспечив в этой предметной области один из самых высоких уровней журналов (средний уровень цитирования), в которых были опубликованы статьи этого университета. Большое число региональных вузов демонстрирует значимые научные результаты в химии, компьютерных, гуманитарных, общественных и экономических науках. И если в первых двух случаях вопросов не возникает, то последние нуждаются в комментариях. Дело в том, что в трех последних предметных областях общее число публикаций российских вузов невелико, и разрыв между явными лидерами и прочими вузами очень значимый. Из-за чего в ранжирование попадают университеты с небольшим числом статей и неустойчивыми научными результатами. Кроме того, в этих предметных областях начинают иметь значение междисциплинарные научные статьи (именно этим объясняется 5-е место ИТМО в рейтинге по экономике – половина его статей в этой предметной области приходится на статьи, связанные с принятием решений). Обратная ситуация также имеет место: НИУ ВШЭ, не имея соответствующего направления подготовки, фигурирует в рейтинге по физике, поскольку ее исследователи публикуются совместно с физиками других вузов.

В заключение отметим, что около трети (!) участников рейтинга используют сомнительные модели (показатель качество роста), выдавая аномально высокий уровень самоцитирования/цитирования своих коллег по университету и/или публикуя исследования в очень ограниченном числе журналов. В их числе нет общепризнанных лидеров, таких как МГУ, СПбГУ, МФТИ, однако замечены несколько университетов из программы 5-100. Это существенная проблема – в погоне за объемами теряется качество, что может привести к удару по репутации – важнейшего показателя международных рейтингов. Эта «болезнь роста» уже привела к попаданию России в «анти-лидеры» по количеству публикаций в недобросовестных журналах («список Белла»), вместе с Индией и Китаем. А сравнив российские вузы по используемому в рейтинге показателю самоцитирования с университетами стран БРИКС мы увидели, что по данному показатели мы уверенно лидируем даже по сравнению с китайскими и индийскими университетами. Наш рейтинг позволил отчасти очистить научные результаты университетов от последствий этой «болезни роста», однако картина полностью прояснится только после того, как будут устранен другой фундаментальный фактор – низкая включенность национальных научных журналов в международные индексы.

Аналитический доклад: Рейтинг университетов буклет

Аналитический доклад: Рейтинг университетов